市場(chǎng)實(shí)際上是算力供給與需求的錯(cuò)配,高質(zhì)量的算力需求遠(yuǎn)遠(yuǎn)不足,低質(zhì)量的算力供給卻找不到太多市場(chǎng)需求。分析認(rèn)為,在經(jīng)歷瘋狂囤積卡資源的智算1.0時(shí)代,到智算中心粗放擴(kuò)張,供需失衡的智算2.0時(shí)代后,智算3.0時(shí)代的終局,一定是專業(yè)化、精細(xì)化運(yùn)營(yíng)的算力服務(wù)。

要想富,先修路。

想要AI大模型能夠持續(xù)迭代升級(jí),離不開底層算力基礎(chǔ)設(shè)施的搭建。自2022年ChatGPT爆發(fā)以來,算力市場(chǎng)也迎來了爆發(fā)式增長(zhǎng)。

一方面,中國(guó)的科技巨頭們,為了搶占未來AGI時(shí)代的門票,正在進(jìn)行的算力“軍備競(jìng)賽”,瘋狂囤積顯卡資源的同時(shí),也正在進(jìn)行從千卡、萬卡再到十萬卡級(jí)別算力集群的建設(shè)。

研究機(jī)構(gòu)Omdia報(bào)告顯示,2024年字節(jié)跳動(dòng)訂購(gòu)了約23萬片英偉達(dá)的芯片,成為英偉達(dá)采購(gòu)數(shù)排名第二的客戶。

有報(bào)道稱,字節(jié)跳動(dòng)2025年的資本開支將達(dá)到1600億元,其中900億將用來購(gòu)買AI算力。與字節(jié)跳動(dòng)同等規(guī)模的大廠,包括阿里、百度、中國(guó)電信(6.910, 0.06, 0.88%)等企業(yè),也都在推進(jìn)十萬卡級(jí)別的算力集群建設(shè)。

而科技巨頭們瘋狂的算力基建行為,無疑也正在不斷將中國(guó)AI算力市場(chǎng)推向高潮。

但巨頭們瘋狂擴(kuò)大算力規(guī)模的另一面,中國(guó)算力市場(chǎng)中卻有大量的算力資源被閑置,甚至開始出現(xiàn)“中國(guó)整體算力資源供過于求”的聲音。

“算力市場(chǎng)2023年非常火,做性能相對(duì)較低的A100的都賺到了錢,但2024年市場(chǎng)冷淡很多,很多卡都沒有拆封。不過各種因素疊加下,面向游戲和消費(fèi)市場(chǎng)的4090仍處于需求更多的狀態(tài)。”云軸科技ZStack CTO王為對(duì)光錐智能說道。

這兩年,算力生意是大模型浪潮中第一個(gè)掘到金的賽道,除了英偉達(dá),也還有無數(shù)云廠商、PaaS層算力優(yōu)化服務(wù)商、甚至芯片掮客們都在前赴后繼。而這一輪算力需求的暴增,主要是由于AI大模型的迅猛發(fā)展所驅(qū)動(dòng)起來的。

AI的需求就像一個(gè)抽水泵,將原來穩(wěn)定多年的算力市場(chǎng)激活,重新激起洶涌的浪花。

但現(xiàn)在,這個(gè)源頭動(dòng)力發(fā)生了改變。AI大模型的發(fā)展,正逐漸從預(yù)訓(xùn)練走向推理應(yīng)用,也有越來越多的玩家開始選擇放棄超大模型的預(yù)訓(xùn)練。比如日前,零一萬物創(chuàng)始人兼CEO李開復(fù)就公開表示,零一萬物不會(huì)停止預(yù)訓(xùn)練,但不再追逐超大模型。

在李開復(fù)看來,如果要追求AGI,不斷訓(xùn)練超大模型,也意味著需要投入更多GPU和資源,“還是我之前的判斷——當(dāng)預(yù)訓(xùn)練結(jié)果已經(jīng)不如開源模型時(shí),每個(gè)公司都不應(yīng)該執(zhí)著于預(yù)訓(xùn)練。”

也正因此,作為曾經(jīng)中國(guó)大模型創(chuàng)業(yè)公司的六小虎之一,零一萬物開始變陣,后續(xù)將押注在AI大模型推理應(yīng)用市場(chǎng)上。

就在這樣一個(gè)需求和供給,都在快速變化的階段,市場(chǎng)的天平在不斷傾斜。

2024年,算力市場(chǎng)出現(xiàn)供需結(jié)構(gòu)性失衡。未來算力基建是否還要持續(xù),算力資源到底該銷往何處,新入局玩家們又該如何與巨頭競(jìng)爭(zhēng),成為一個(gè)個(gè)關(guān)鍵命題。

一場(chǎng)圍繞智能算力市場(chǎng)的隱秘江湖,正徐徐拉開帷幕。

供需錯(cuò)配:低質(zhì)量的擴(kuò)張,碰上高質(zhì)量需求

1997年,還很年輕的劉淼,加入了當(dāng)時(shí)發(fā)展如日中天的IBM,這也使其一腳就邁入了計(jì)算行業(yè)。

20世紀(jì)中葉,IBM開發(fā)的大型主機(jī)被譽(yù)為“藍(lán)色巨人”,幾乎壟斷了全球的企業(yè)計(jì)算市場(chǎng)。

“當(dāng)時(shí)IBM的幾臺(tái)大型主機(jī),就能夠支撐起一家銀行在全國(guó)的核心業(yè)務(wù)系統(tǒng)的運(yùn)行,這也讓我看到了計(jì)算讓業(yè)務(wù)系統(tǒng)加速的價(jià)值。”劉淼對(duì)光錐智能說道。

也正是在IBM的經(jīng)歷,為劉淼后續(xù)投身新一代智算埋下伏筆。

而在經(jīng)歷了以CPU為代表的主機(jī)時(shí)代、云計(jì)算時(shí)代后,當(dāng)前算力已進(jìn)入到以GPU為主的智算時(shí)代,其整個(gè)計(jì)算范式也發(fā)生了根本改變,畢竟如果沿用老的架構(gòu)方案,就需要把大量數(shù)據(jù)通過CPU繞行再通往GPU,這就導(dǎo)致GPU的大算力和大帶寬被浪費(fèi)。而GPU訓(xùn)練和推理場(chǎng)景,也對(duì)高速互聯(lián)、在線存儲(chǔ)和隱私安全提出了更高的要求。

這也就催生了中國(guó)智能算力產(chǎn)業(yè)鏈上下游的發(fā)展,尤其是以智算中心為主的基礎(chǔ)設(shè)施建設(shè)。

2022年底,ChatGPT的發(fā)布正式開啟AI大模型時(shí)代,中國(guó)也隨之進(jìn)入“百模大戰(zhàn)”階段。

彼時(shí)各家都希望能夠給大模型預(yù)訓(xùn)練提供算力,而行業(yè)中也存在并不清楚最終算力需求在哪,以及誰(shuí)來用的情況,“這一階段大家會(huì)優(yōu)先買卡,做一種資源的囤積。”圖靈新智算聯(lián)合創(chuàng)始人兼研究院院長(zhǎng)洪銳說道,這也是智算1.0時(shí)代。

隨著大模型訓(xùn)練參數(shù)越來越大,最終發(fā)現(xiàn)真正算力資源消納方,集中到了做預(yù)訓(xùn)練的玩家上。

“這一輪AI產(chǎn)業(yè)爆發(fā)的前期,就是希望通過在基礎(chǔ)模型預(yù)訓(xùn)練上不斷擴(kuò)大算力消耗,探索通往AGI(通用人工智能)的道路。”洪銳說道。

公開數(shù)據(jù)顯示,ChatGPT的訓(xùn)練參數(shù)已經(jīng)達(dá)到了1750億、訓(xùn)練數(shù)據(jù)45TB,每天生成45億字的內(nèi)容,支撐其算力至少需要上萬顆英偉達(dá)的GPU A100,單次模型訓(xùn)練成本超過1200萬美元。

另外,2024年多模態(tài)大模型猶如神仙打架,視頻、圖片、語(yǔ)音等數(shù)據(jù)的訓(xùn)練對(duì)算力提出了更高的需求。

公開數(shù)據(jù)顯示,OpenAI的Sora視頻生成大模型訓(xùn)練和推理所需要的算力需求分別達(dá)到了GPT-4的4.5倍和近400倍。中國(guó)銀河(14.230, 0.29, 2.08%)證券研究院的報(bào)告也顯示,Sora對(duì)算力需求呈指數(shù)級(jí)增長(zhǎng)。

因此,自2023年開始,除各方勢(shì)力囤積顯卡資源之外,為滿足更多算力需求,中國(guó)算力市場(chǎng)迎來爆發(fā)式增長(zhǎng),尤其是智算中心。

賽迪顧問人工智能與大數(shù)據(jù)研究中心高級(jí)分析師白潤(rùn)軒此前表示:“從2023年開始,各地政府加大了對(duì)智算中心的投資力度,推動(dòng)了基礎(chǔ)設(shè)施的發(fā)展。”

在市場(chǎng)和政策的雙重影響下,中國(guó)智算中心在短短一兩年時(shí)間如雨后春筍般快速建設(shè)起來。

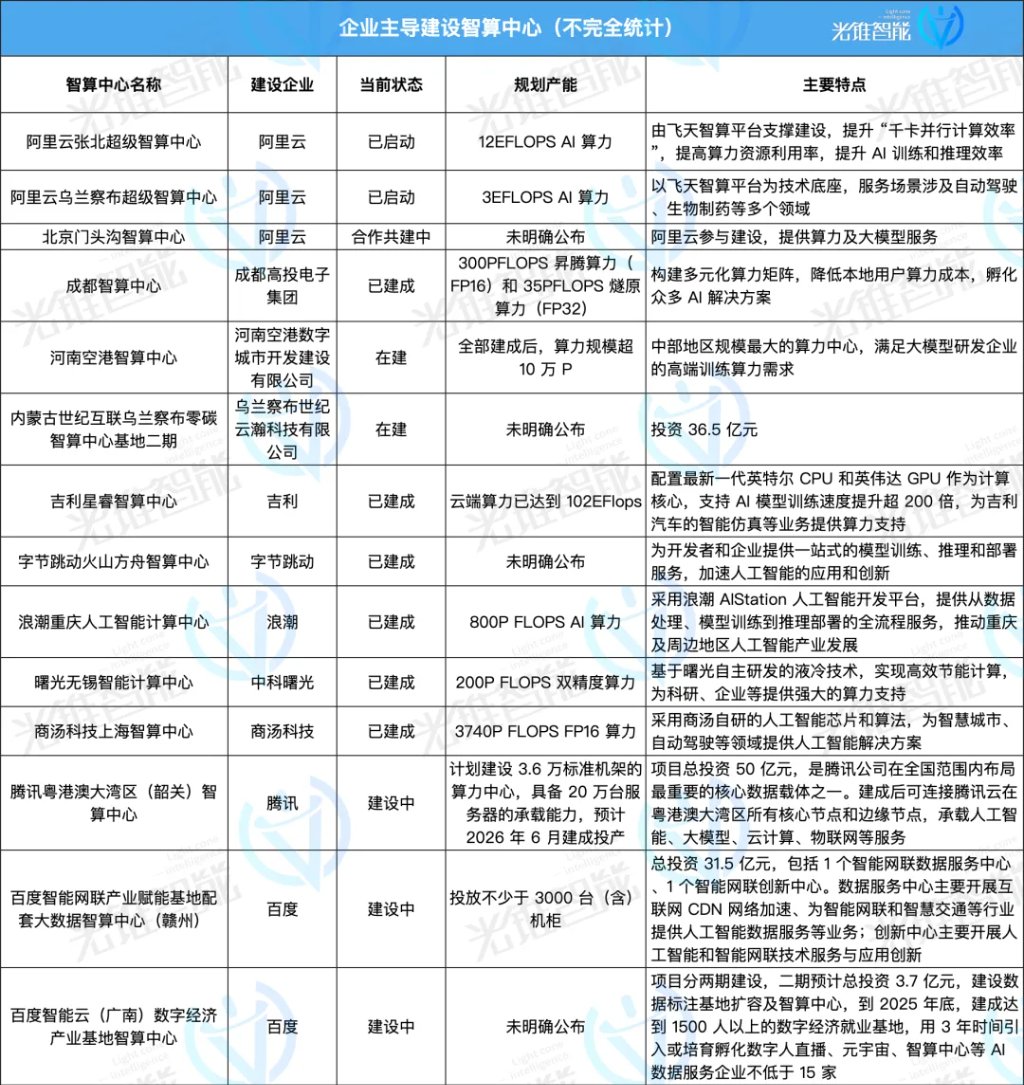

這其中既有政府主導(dǎo)建設(shè)項(xiàng)目,也有以阿里云、百度智能云、商湯等企業(yè)為主開始投資建設(shè)的智算中心,更有一些跨界企業(yè)看到其中的機(jī)會(huì)從而邁入這一賽道。

同時(shí),還有像圖靈新智算、趨境科技、硅基流動(dòng)等創(chuàng)業(yè)公司進(jìn)入到算力行業(yè)。

相關(guān)數(shù)據(jù)顯示,截至2024年上半年,國(guó)內(nèi)已經(jīng)建設(shè)和正在建設(shè)的智算中心超過250個(gè),2024年上半年智算中心招投標(biāo)相關(guān)事件791起,同比增長(zhǎng)高達(dá)407.1%。

但是,智算中心的建設(shè)并非簡(jiǎn)單的修橋鋪路,一是對(duì)技術(shù)和專業(yè)度的要求很高,二是建設(shè)和需求往往存在錯(cuò)配,三是對(duì)持續(xù)的規(guī)劃不足。

在劉淼看來,智算中心其實(shí)是中國(guó)獨(dú)特的產(chǎn)物,某種程度上承擔(dān)了部分支持本地產(chǎn)業(yè)發(fā)展的社會(huì)使命,但不是純市場(chǎng)化的行為帶來一大問題,就是在長(zhǎng)達(dá)12-24個(gè)月建設(shè)周期后,“建好了就閑置了,因?yàn)橐呀?jīng)不能滿足2年后行業(yè)對(duì)算力需求了。”

從當(dāng)前來看,中國(guó)算力市場(chǎng)資源在某些區(qū)域確實(shí)出現(xiàn)閑置。“中國(guó)算力市場(chǎng)現(xiàn)階段問題的根源,就在于太粗放了。”劉淼說道。

不過,市場(chǎng)不能簡(jiǎn)單講是供需過剩,或者供需不足,實(shí)際上是算力供給與需求的錯(cuò)配。即高質(zhì)量的算力需求遠(yuǎn)遠(yuǎn)不足,但低質(zhì)量的算力供給卻找不到太多的市場(chǎng)需求。畢竟,大模型預(yù)訓(xùn)練玩家往往需要萬卡以上的算力資源池。

然而,中國(guó)算力市場(chǎng)上前期部分智算中心的規(guī)模,“可能只有幾十臺(tái)到一兩百臺(tái),這對(duì)于當(dāng)前基礎(chǔ)模型的預(yù)訓(xùn)練來說是遠(yuǎn)遠(yuǎn)不夠的,但設(shè)備選型是匹配的預(yù)訓(xùn)練需求。”洪銳表示,站在預(yù)訓(xùn)練角度,算力確實(shí)稀缺,但由于規(guī)模達(dá)不到而不能用的算力放在那里就成了閑置。

大模型賽道分化 算力需求悄然轉(zhuǎn)變

大模型市場(chǎng)的發(fā)展變化太快了。

原本在大模型預(yù)訓(xùn)練階段,行業(yè)中玩家希望能夠通過不停的訓(xùn)練來提升大模型效果,如果這一代不行,就花更多算力、更多資金去訓(xùn)練下一代大模型。

“之前大模型賽道發(fā)展邏輯是這樣的,但到了2024年6月份左右,行業(yè)中能夠明顯感知到,大模型預(yù)訓(xùn)練這件事已經(jīng)到了投入產(chǎn)出的臨界點(diǎn),投入巨量資源做預(yù)訓(xùn)練,也可能達(dá)不到預(yù)期收益。”洪銳表示。

背后很重要的原因,在于“OpenAI技術(shù)演進(jìn)的問題,GPT-3.5的能力很震撼,GPT-4的能力有提升,但是從2023年年中到2024年,整體的基座模型能力的升級(jí)達(dá)不到2023年的效果,再多的提升在CoT和Agent側(cè)。”王為如此說道。

基礎(chǔ)模型能力升級(jí)放緩的同時(shí),預(yù)訓(xùn)練的成本也非常高昂。

此前零一萬物創(chuàng)始人兼CEO李開復(fù)所言,一次預(yù)訓(xùn)練成本約三四百萬美元。這對(duì)于大多數(shù)中小企業(yè)而言,無疑是一項(xiàng)高額成本投入,“創(chuàng)業(yè)公司的生存之道,是要考慮怎么樣去善用每一塊錢,而不是弄更多GPU來燒。”

因此,隨著大模型參數(shù)越來越大,越來越多的企業(yè)無法承擔(dān)大模型訓(xùn)練成本,只能基于已經(jīng)訓(xùn)練好的模型進(jìn)行應(yīng)用或者微調(diào)。“甚至可以說,當(dāng)大模型參數(shù)達(dá)到一定程度后,大部分企業(yè)連微調(diào)能力都不具備。”洪銳說道。

有相關(guān)數(shù)據(jù)統(tǒng)計(jì),2024年下半年,在通過備案的大模型中,有接近50%轉(zhuǎn)向了AI應(yīng)用。

大模型從預(yù)訓(xùn)練走向推理應(yīng)用,無疑也帶來了算力市場(chǎng)需求的分化。洪銳認(rèn)為:“大模型預(yù)訓(xùn)練的計(jì)算中心和算力需求,以及推理應(yīng)用的算力需求,其實(shí)已經(jīng)是兩條賽道了。”

從大模型預(yù)訓(xùn)練角度來說,其所需要的算力與模型參數(shù)量、訓(xùn)練數(shù)據(jù)量成正比,算力集群規(guī)模的整體要求是:百億參數(shù)用百卡,千億參數(shù)用千卡,萬億參數(shù)用萬卡。

另外,大模型預(yù)訓(xùn)練的一個(gè)重要特征,就是不能中斷,一旦中斷所有訓(xùn)練都需要從CheckPoint重頭開始。

“去年至今,國(guó)內(nèi)引進(jìn)了大量智算設(shè)備,但平均故障率卻在10%-20%左右,如此高的故障率導(dǎo)致大模型訓(xùn)練每三小時(shí)就要斷一次。”劉淼說道,“一個(gè)千卡集群,基本上20天就要斷一次。”

同時(shí),為了支持人工智能走向Agent時(shí)代甚至未來的通用人工智能,需要不斷擴(kuò)大算力集群,從千卡集群邁向萬卡集群甚至十萬卡,“馬斯克是個(gè)牛人,規(guī)劃了孟菲斯十萬卡集群,首個(gè)1.9萬卡,從安裝到點(diǎn)亮,只花了19天,其復(fù)雜程度要遠(yuǎn)遠(yuǎn)高出現(xiàn)有的項(xiàng)目。”劉淼說道。

(馬斯克此前在X上宣布啟用10萬卡規(guī)模的孟菲斯超級(jí)集群)

目前國(guó)內(nèi)為了滿足更高參數(shù)大模型的訓(xùn)練,也都在積極投建萬卡算力池,但“大家會(huì)發(fā)現(xiàn),算力供應(yīng)商的客戶其實(shí)都集中在頭部的幾個(gè)企業(yè),且會(huì)要求這些企業(yè)簽訂長(zhǎng)期的算力租賃協(xié)議,不管你是否真的需要這些算力。”中國(guó)電信大模型首席專家、大模型團(tuán)隊(duì)負(fù)責(zé)人劉敬謙如此說道。

不過,洪銳認(rèn)為;“未來全球真正能夠有實(shí)力做預(yù)訓(xùn)練的玩家不超過50家,且智算集群規(guī)模到了萬卡、十萬卡后,有能力做集群運(yùn)維故障排除和性能調(diào)優(yōu)的玩家也會(huì)越來越少。”

現(xiàn)階段,已經(jīng)有大量中小企業(yè)從大模型的預(yù)訓(xùn)練轉(zhuǎn)向了AI推理應(yīng)用,且“大量的AI推理應(yīng)用,往往是短時(shí)間、短期間的潮汐式應(yīng)用。”劉敬謙說道。但部署在實(shí)際終端場(chǎng)景中時(shí),會(huì)需要大量服務(wù)器進(jìn)行并行網(wǎng)絡(luò)計(jì)算,推理成本會(huì)驟然提升。

“原因是延遲比較高,大模型回答一個(gè)問題需要經(jīng)過深層次推理思考,這段時(shí)間大模型一直在進(jìn)行計(jì)算,這也意味著幾十秒內(nèi)這臺(tái)機(jī)器的計(jì)算資源被獨(dú)占。如果拓展至上百臺(tái)服務(wù)器,則推理成本很難被覆蓋。”趨鏡科技CEO艾智遠(yuǎn)對(duì)光錐智能稱。

因此,相較于需要大規(guī)模算力的AI(大模型)訓(xùn)練場(chǎng)景,AI推理對(duì)算力性能要求沒有AI訓(xùn)練嚴(yán)苛,主要是滿足低功耗和實(shí)時(shí)處理的需求。“訓(xùn)練集中于電力高地,推理則要靠近用戶。”華為公司副總裁、ISP與互聯(lián)網(wǎng)系統(tǒng)部總裁岳坤說道,推理算力的延時(shí)要在5-10毫秒范圍內(nèi),并且需要高冗余設(shè)計(jì),實(shí)現(xiàn)“兩地三中心”建設(shè)。

以中國(guó)電信為例,其目前已在北京、上海、廣州、寧夏等地建立萬卡資源池,為了支持行業(yè)模型發(fā)展,也在浙江、江蘇等七個(gè)地方建立千卡資源池。同時(shí),為了保證AI推理應(yīng)用的低延時(shí)在10毫秒圈子里,中國(guó)電信也在多地區(qū)建設(shè)邊端推理算力,逐漸形成全國(guó)“2+3+7”算力布局。

2024年,被稱作AI應(yīng)用落地元年,但實(shí)際上,AI推理應(yīng)用市場(chǎng)并未如預(yù)期中迎來爆發(fā)。主要原因在于,“目前行業(yè)中尚未出現(xiàn)一款能夠在企業(yè)中大規(guī)模鋪開的應(yīng)用,畢竟大模型本身技術(shù)能力還有缺陷,基礎(chǔ)模型不夠強(qiáng),存在幻覺、隨機(jī)性等問題。”洪銳說道。

由于AI應(yīng)用普遍尚未爆發(fā),推理的算力增長(zhǎng)也出現(xiàn)了停滯。不過,很多從業(yè)者依然樂觀——他們判斷,智能算力仍會(huì)是“長(zhǎng)期短缺”,隨著AI應(yīng)用的逐漸滲透,推理算力需求的增長(zhǎng)是個(gè)確定趨勢(shì)。

一位芯片企業(yè)人士對(duì)光錐智能表示,AI推理其實(shí)是在不斷嘗試追求最佳解,Agent(智能體)比普通的LLM(大語(yǔ)言模型)所消耗的Token更多,因?yàn)槠洳煌5卦谶M(jìn)行觀察、規(guī)劃和執(zhí)行,“o1是模型內(nèi)部做嘗試,Agent是模型外部做嘗試。”

因此,“預(yù)估明年會(huì)有大量AI推理算力需求爆發(fā)出來。”劉敬謙說道,“我們也建立了大量的輕型智算集群解決方案和整個(gè)邊端推理解決方案。”

王為也表示;“如果算力池中卡量不大的情況下,針對(duì)預(yù)訓(xùn)練的集群算力很難出租。推理市場(chǎng)所需要訓(xùn)練卡量并不多,且整個(gè)市場(chǎng)還在穩(wěn)定增長(zhǎng),中小互聯(lián)網(wǎng)企業(yè)需求量在持續(xù)增加。”

不過現(xiàn)階段,訓(xùn)練算力仍占據(jù)主流。據(jù)IDC、浪潮信息(52.960, 1.22, 2.36%)聯(lián)合發(fā)布的《2023-2024年中國(guó)人工智能計(jì)算力發(fā)展評(píng)估報(bào)告》,2023年國(guó)內(nèi)AI服務(wù)器工作負(fù)載中訓(xùn)練:推理的占比約為6:4。

2024年8月,英偉達(dá)管理層在2024年二季度財(cái)報(bào)電話會(huì)中表示,過去四個(gè)季度中,推理算力占英偉達(dá)數(shù)據(jù)中心收入約為40%。在未來,推理算力的收入將持續(xù)提升。12月25日,英偉達(dá)宣布推出兩款為滿足推理大模型性能需要的GPU GB300和B300。

無疑,大模型從預(yù)訓(xùn)練走向推理應(yīng)用,帶動(dòng)了算力市場(chǎng)需求的分化。從整個(gè)算力市場(chǎng)來說,當(dāng)前智算中心還處于發(fā)展初期,基礎(chǔ)設(shè)施建設(shè)并不完善。因此,大型預(yù)訓(xùn)練玩家或者大型企業(yè),會(huì)更傾向于自己囤積顯卡。而針對(duì)AI推理應(yīng)用賽道,智算中心提供設(shè)備租賃時(shí),大部分中小客戶會(huì)更傾向于零租,且會(huì)更注重性價(jià)比。

未來,隨著AI應(yīng)用滲透率不斷提升,推理算力消耗量還會(huì)持續(xù)提升。按照IDC預(yù)測(cè)結(jié)果,2027年推理算力在智能算力大盤中的占比甚至?xí)^70%。

而如何通過提升計(jì)算效率,來降低推理部署成本,則成為了AI推理應(yīng)用算力市場(chǎng)發(fā)展的關(guān)鍵。

不盲目堆卡,如何提升算力利用率?

整體來說,自2021年正式啟動(dòng)“東數(shù)西算”建設(shè)以來,中國(guó)市場(chǎng)并不缺底層算力資源,甚至隨著大模型技術(shù)發(fā)展和算力需求的增長(zhǎng),算力市場(chǎng)中大量購(gòu)買基建的熱潮,還會(huì)持續(xù)一兩年時(shí)間。

但這些底層算力資源卻有一個(gè)共性,即四處分散,且算力規(guī)模小。劉敬謙表示:“每個(gè)地方可能只有100臺(tái)或200臺(tái)左右算力,遠(yuǎn)遠(yuǎn)不能夠滿足大模型算力需求。”

另外,更為重要的是,當(dāng)前算力的計(jì)算效率并不高。

有消息顯示,即使是OpenAI,在GPT-4的訓(xùn)練中,算力利用率也只有32%-36%,大模型訓(xùn)練的算力有效利用率不足50%。“我國(guó)算力的利用率只有30%。”中國(guó)工程院院士鄔賀銓坦言。

原因在于,大模型訓(xùn)練周期內(nèi),GPU卡并不能隨時(shí)實(shí)現(xiàn)高資源利用,在一些訓(xùn)練任務(wù)比較小的階段,還會(huì)有資源閑置狀態(tài)。在模型部署階段,由于業(yè)務(wù)波動(dòng)和需求預(yù)測(cè)不準(zhǔn)確,許多服務(wù)器往往也會(huì)處于待機(jī)或低負(fù)載狀態(tài)。

“云計(jì)算時(shí)代的CPU服務(wù)器整體發(fā)展已經(jīng)非常成熟,通用計(jì)算的云服務(wù)可用性要求是99.5%~99.9%,但大規(guī)模GPU集群非常難做到。”洪銳表示。

這背后,還在于GPU整體硬件發(fā)展以及整個(gè)軟件生態(tài)的不充足。軟件定義硬件,也正逐漸成為智能算力時(shí)代發(fā)展的關(guān)鍵。

因此,在智能算力江湖中,圍繞智能算力基礎(chǔ)設(shè)施建設(shè),整合社會(huì)算力閑置資源,并通過軟件算法等方式提高算力計(jì)算效率,各類玩家憑借自己的核心優(yōu)勢(shì)入局,并圈地跑馬。

這些玩家大致可以分為三類:

一類是大型國(guó)資央企,比如中國(guó)電信,基于其央企身份能夠更好的滿足國(guó)資、央企的算力需求。

一方面,中國(guó)電信自己構(gòu)建了千卡、萬卡和十萬卡算力資源池。另一方面,通過息壤·智算一體化平臺(tái),中國(guó)電信也正在積極整合社會(huì)算力閑置資源,可實(shí)現(xiàn)跨服務(wù)商、跨地域、夸架構(gòu)的統(tǒng)一管理,統(tǒng)一調(diào)度,提高算力資源的整體利用率。

“我們先做的是國(guó)資央企的智算調(diào)度平臺(tái),通過將400多個(gè)社會(huì)不同閑置算力資源整合至同一個(gè)平臺(tái),然后連接國(guó)資央企的算力需求,從而解決算力供需不平衡問題。”劉敬謙說道。

一類是以互聯(lián)網(wǎng)公司為主的云廠商,包括阿里云、百度智能云、火山引擎等,這些云廠商在底層基礎(chǔ)設(shè)施架構(gòu)上正積極從CPU云轉(zhuǎn)型至GPU云,并形成以GPU云為核心的全棧技術(shù)能力。

“下一個(gè)十年,計(jì)算范式將從云原生,進(jìn)入到AI云原生的新時(shí)代。”火山引擎總裁譚待此前說道,AI云原生,將以GPU為核心重新來優(yōu)化計(jì)算、存儲(chǔ)與網(wǎng)絡(luò)架構(gòu),GPU可以直接訪問存儲(chǔ)和數(shù)據(jù)庫(kù),來顯著的降低IO延遲。

從底層基礎(chǔ)設(shè)施來看,智算中心的建設(shè)往往并不是以單一品牌GPU顯卡為主,更多的可能是英偉達(dá)+國(guó)產(chǎn)GPU顯卡,甚至?xí)嬖谕ㄟ^CPU、GPU、FPGA(可編程芯片)、ASIC(為特定場(chǎng)景設(shè)計(jì)的芯片)等多種不同類型的計(jì)算單元協(xié)同工作的異構(gòu)算力情況,以滿足不同場(chǎng)景下的計(jì)算需求,實(shí)現(xiàn)計(jì)算效力的最大化。

因此,云廠商們也針對(duì)“多芯混訓(xùn)”的能力,進(jìn)行了重點(diǎn)升級(jí)。比如今年9月,百度智能云將百舸AI異構(gòu)計(jì)算平臺(tái)全面升級(jí)至4.0版本,實(shí)現(xiàn)了在萬卡規(guī)模集群上95%的多芯混合訓(xùn)練效能。

而在底層基礎(chǔ)設(shè)施之上,影響大模型訓(xùn)練和推理應(yīng)用部署的,除了GPU顯卡性能之外,還與網(wǎng)絡(luò)、存儲(chǔ)產(chǎn)品、數(shù)據(jù)庫(kù)等軟件工具鏈平臺(tái)息息相關(guān),而處理速度的提升,往往需要多個(gè)產(chǎn)品共同加速完成。

當(dāng)然,除云大廠外,還有一批中小云廠商以自己的差異化視角切入到算力行業(yè)中,如云軸科技——基于平臺(tái)能力,做算力資源的調(diào)度和管理。

王為坦言,“之前GPU在業(yè)務(wù)系統(tǒng)架構(gòu)中還只是附件,后續(xù)才逐漸成為單獨(dú)的類別。”

今年8月份,云軸科技發(fā)布了新一代AI Infra基礎(chǔ)設(shè)施ZStack AIOS平臺(tái)智塔,這一平臺(tái)主要以AI企業(yè)級(jí)應(yīng)用為核心,從“算力調(diào)度、AI大模型訓(xùn)推、AI應(yīng)用服務(wù)開發(fā)”三個(gè)方向幫助企業(yè)客戶進(jìn)行大模型新應(yīng)用的落地部署。

“我們會(huì)通過平臺(tái)統(tǒng)計(jì)算力具體的使用情況、對(duì)算力進(jìn)行運(yùn)維,同時(shí)在GPU顯卡有限的場(chǎng)景下,想要提升算力利用率,也會(huì)為客戶切分算力。”王為說道。

此外,在運(yùn)營(yíng)商場(chǎng)景中,算力的資源池比較多,“我們也會(huì)跟客戶進(jìn)行合作,幫助其進(jìn)行資源池的運(yùn)營(yíng)、計(jì)算、統(tǒng)一運(yùn)營(yíng)管理等。”王為表示。

另一類玩家,是基于算法提升算力計(jì)算效率的創(chuàng)業(yè)公司,如圖靈新智算、趨鏡科技、硅基流動(dòng)等。這些新玩家,綜合實(shí)力遠(yuǎn)弱于云大廠們,但通過單點(diǎn)技術(shù)突圍,也逐漸在行業(yè)中占據(jù)一席之地。

“最開始我們是智算集群生產(chǎn)制造服務(wù)商,到連接階段,則是算力運(yùn)營(yíng)服務(wù)商,未來成為智能數(shù)據(jù)和應(yīng)用服務(wù)商,這三個(gè)角色不斷演變。”劉淼說道,“所以我們定位是,新一代算力運(yùn)營(yíng)服務(wù)廠商。”

圖靈新智算未來希望,搭建獨(dú)立的整合算力閑置資源的平臺(tái),能夠進(jìn)行算力的調(diào)度、出租和服務(wù)。“我們打造一個(gè)資源平臺(tái),將閑置算力接入平臺(tái),類似于早期的淘寶平臺(tái)。”劉淼說道,閑置算力主要對(duì)接的是各地區(qū)智算中心。

與之相比,趨境科技、硅基流動(dòng)等企業(yè),更聚焦在AI推理應(yīng)用市場(chǎng)中,并更注重以算法的能力,來提升算力的效率,降低大模型推理應(yīng)用的成本,只不過各家方案的切入點(diǎn)并不相同。

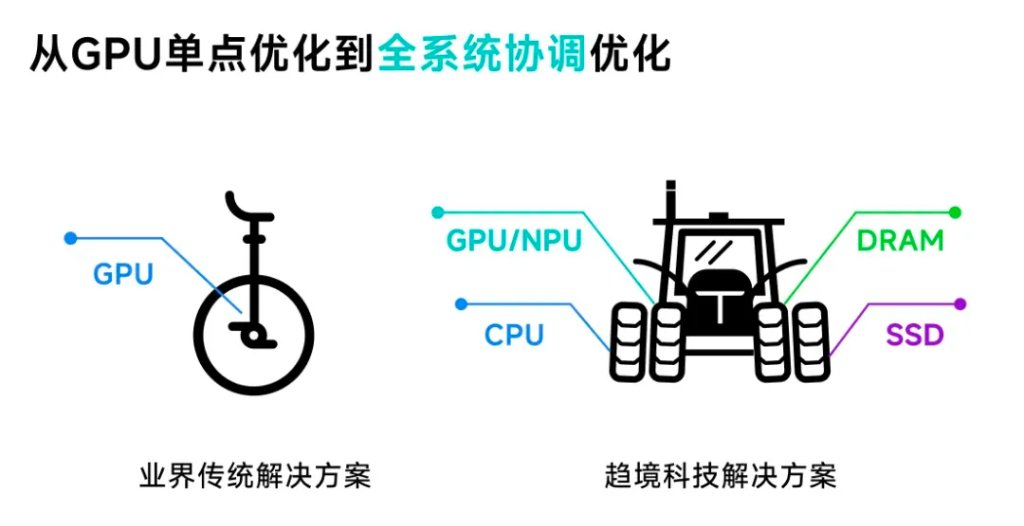

比如趨境科技為了解決大模型不可能三角,及效果、效率和成本之間的平衡,提出了全系統(tǒng)異構(gòu)協(xié)同推理和針對(duì)AI推理應(yīng)用的RAG(搜索增強(qiáng))場(chǎng)景,采用“以存換算”的方式釋放存力作為對(duì)于算力的補(bǔ)充兩大創(chuàng)新技術(shù)策略,將推理成本降低 10 倍,響應(yīng)延遲降低 20 倍。

而面向未來,除了持續(xù)優(yōu)化連接底層算力資源和上層應(yīng)用的中間AI infra層外,“我們更希望的一種模式是,我們搭的是一個(gè)架子,房頂上的這些應(yīng)用是由大家來開發(fā),然后利用我們架子能夠更好的降低成本。”趨境科技創(chuàng)始人兼CEO艾智遠(yuǎn)如此說道。

不難看出,趨境科技并不只是想做算法優(yōu)化解決方案供應(yīng)商,還想做AI大模型落地應(yīng)用服務(wù)商。

另外,當(dāng)前行業(yè)中針對(duì)大模型算力優(yōu)化方案,往往會(huì)優(yōu)先考慮提升GPU的利用率。艾智遠(yuǎn)表示,現(xiàn)階段對(duì)GPU的利用率已經(jīng)達(dá)到50%以上,想要在提高GPU的利用率,難度非常大。

“GPU利用率還存在很大提升空間,但非常難,涉及到芯片、顯存、卡間互聯(lián)、多機(jī)通訊和軟件調(diào)度等技術(shù),這并不是一家公司或一門技術(shù)能夠解決,而是需要整個(gè)產(chǎn)業(yè)鏈上下游共同推動(dòng)。”洪銳也如此對(duì)光錐智能說道。

洪銳認(rèn)為,目前行業(yè)缺乏真正能夠從技術(shù)上將超大規(guī)模智算集群組網(wǎng)運(yùn)維起來的能力,同時(shí)軟件層并未發(fā)展成熟,“算力就在這,但如果軟件優(yōu)化沒做好,或推理引擎和負(fù)載均衡等沒做好,對(duì)算力性能的影響也非常大。”

縱觀這三大類玩家,不管是中國(guó)電信等運(yùn)營(yíng)商,還是云廠商們,亦或是新入局的玩家,各自切入算力市場(chǎng)的方式不盡相同,但都希望在這一場(chǎng)全球算力的盛宴中分得一杯羹。

事實(shí)上,現(xiàn)階段相比大模型服務(wù),這的確也是確定性更強(qiáng)的生意。

算力租賃同質(zhì)化,精細(xì)化、專業(yè)化運(yùn)營(yíng)服務(wù)為王

從賺錢的穩(wěn)定度上,淘金者很難比得上賣水人。

AI大模型已經(jīng)狂奔兩年,但整個(gè)產(chǎn)業(yè)鏈中,只有以英偉達(dá)為首的算力服務(wù)商真正賺到了錢,在收入和股市上都名利雙收。

而在2024年,算力的紅利在逐步從英偉達(dá)延伸到泛算力賽道上,服務(wù)器廠商、云廠商,甚至倒賣、租賃各種卡的玩家,也獲得了一定利潤(rùn)回報(bào)。當(dāng)然,利潤(rùn)遠(yuǎn)遠(yuǎn)小于英偉達(dá)。

“2024年整體上沒虧錢,但是也沒賺到很多錢。”王為坦言,“AI(應(yīng)用)現(xiàn)階段還沒有起量,跟AI相關(guān)量最大的還是算力層,算力應(yīng)用營(yíng)收相對(duì)較好。”

對(duì)于2025年的發(fā)展預(yù)期,王為也直言并未做好完全的預(yù)測(cè),“明年真的有點(diǎn)不好說,但遠(yuǎn)期來看,未來3年AI應(yīng)用將會(huì)有很大的增量進(jìn)展。”

但以各地智算中心的發(fā)展情況來看,卻鮮少能夠?qū)崿F(xiàn)營(yíng)收,基本目標(biāo)都是覆蓋運(yùn)營(yíng)成本。

據(jù)智伯樂科技CEO岳遠(yuǎn)航表示,經(jīng)測(cè)算后發(fā)現(xiàn),一個(gè)智算中心縱使設(shè)備出租率漲到60%,至少還要花上7年以上的時(shí)間才能回本。

目前智算中心對(duì)外主要以提供算力租賃為主要營(yíng)收方式,但“設(shè)備租賃非常同質(zhì)化,真正缺失的是一種端到端的服務(wù)能力。”洪銳對(duì)光錐智能說道。

所謂的端到端服務(wù)能力,即除硬件之外,智算中心還要能夠支持企業(yè)從大模型應(yīng)用開發(fā),到大模型的迭代升級(jí),再到后續(xù)大模型部署的全棧式服務(wù)。而目前能夠真正實(shí)現(xiàn)這種端到端服務(wù)的廠商,相對(duì)比較少。

不過,從整體數(shù)據(jù)來看,中國(guó)智算服務(wù)市場(chǎng)發(fā)展前景越來越樂觀。據(jù)IDC最新發(fā)布《中國(guó)智算服務(wù)市場(chǎng)(2024上半年)跟蹤》報(bào)告顯示,2024年上半年中國(guó)智算服務(wù)整體市場(chǎng)同比增長(zhǎng)79.6%,市場(chǎng)規(guī)模達(dá)到146.1億元人民幣。“智算服務(wù)市場(chǎng)以遠(yuǎn)超預(yù)期的增速在高速成長(zhǎng)。從智算服務(wù)的增長(zhǎng)態(tài)勢(shì)來看,智算服務(wù)市場(chǎng)在未來五年內(nèi)仍將保持高速成長(zhǎng)。”IDC中國(guó)企業(yè)級(jí)研究部研究經(jīng)理?xiàng)钛蟊硎尽?/P>

洪銳也表示,在經(jīng)歷瘋狂囤積卡資源的智算1.0時(shí)代,到智算中心粗放擴(kuò)張,供需失衡的智算2.0時(shí)代后,智算3.0時(shí)代的終局,一定是專業(yè)化、精細(xì)化運(yùn)營(yíng)的算力服務(wù)。

畢竟,當(dāng)預(yù)訓(xùn)練和推理分成兩個(gè)賽道后,AI推理應(yīng)用市場(chǎng)會(huì)逐漸發(fā)展起來,技術(shù)棧也會(huì)逐漸成熟,服務(wù)能力逐漸完善,市場(chǎng)也將進(jìn)一步整合零散閑置算力資源,實(shí)現(xiàn)算力利用率最大化。

不過,當(dāng)前中國(guó)算力市場(chǎng)也仍面臨著巨大挑戰(zhàn)。在高端GPU芯片短缺的同時(shí),“現(xiàn)在國(guó)內(nèi)GPU市場(chǎng)過于碎片化,且各家GPU都有獨(dú)立的生態(tài)體系,整體的生態(tài)存在割裂。”王為如此說道,這也就導(dǎo)致國(guó)內(nèi)整個(gè)GPU生態(tài)的適配成本非常高。

但就像劉淼所言,智算的20年長(zhǎng)周期才剛剛開始,現(xiàn)在或許僅僅只是第一年。而在實(shí)現(xiàn)AGI這條道路上,也充滿著不確定性,這對(duì)于眾多玩家來說,無疑充滿著更多的機(jī)遇和挑戰(zhàn)。