2月24日,在上周DeepSeek宣布本周將是開源周(OpenSourceWeek),并將連續開源五個軟件庫后。今日上午9:30時許,DeepSeek宣布開源了本次開源周首款代碼庫——針對Hopper GPU進行優化的高效型MLA解碼核——FlashMLA。

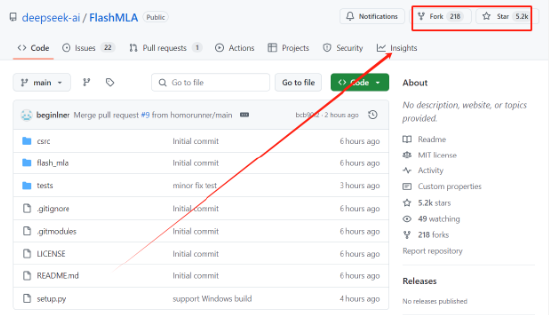

新浪科技注意到,在GitHub上,目前該項目開源6小時后便已收獲了超過5000Star收藏,并且擁有188個Fork(副本創建)。在聽到DeepSeek開源FlashMLA并迎來的快速的Star收藏和Fork數據增長后,某港股上市公司CTO在與新浪科技溝通中直呼:“太強了”。

另有專注于AI硬件研究并投資的投資人,在查看FlashMLA后告訴新浪科技,對于國產GPU而言,此次開源算是重大利好。“此前的國產GPU卡,很弱。那現在可以通過FlashMLA提供的優化思路和方法論,嘗試讓國產卡大幅提升性能,即使架構不同,后面國產卡的推理性能提升將是順理成章的事兒”。

據DeepSeek官方介紹,FlashMLA基于Hopper GPUs的有效MLA解碼內核,可針對可變長度序列進行優化。

在DeepSeek整個技術路線中,MLA(多頭潛在注意力機制)是公司已經發布的V2、V3兩款模型中,最為核心的技術之一。被用于解決計算效率和內存占用上的性能瓶頸,能夠顯著提升模型訓練和推理效率,同時保持甚至增強模型性能。

此前,中國工程院院士、清華大學計算機系教授鄭緯民在與新浪科技溝通中曾提及:“DeepSeek自研的MLA架構為其自身的模型訓練成本下降,起到了關鍵作用。”他指出,“MLA通過改造注意力算子壓縮了KV Cache大小,實現了在同樣容量下可以存儲更多的KV Cache,該架構和DeepSeek-V3模型中FFN 層的改造相配合,實現了一個非常大的稀疏MoE 層,成為DeepSeek訓練成本低最關鍵的原因。”

此次DeepSeek直接開放MLA解碼核——FlashMLA,意味著DeepSeek將最為核心的MLA底層代碼直接免費開放,這讓廣大開發群體可以直接復用FlashMLA代碼庫實現用更少的GPU服務器完成同樣的任務,直接降低推理成本,這對于更多希望基于DeepSeek開源能力進行底層優化和AI應用開發群體而言,無疑是一大福利。

有意思的是,DeepSeek此次開放的MLA解碼核,主要是針對Hopper GPU進行優化用途的。通常而言,Hopper GPU是指基于英偉達Hopper架構研發的H系列GPU產品。目前,英偉達該系列芯片已經發布H100、H800和H20等多款芯片。

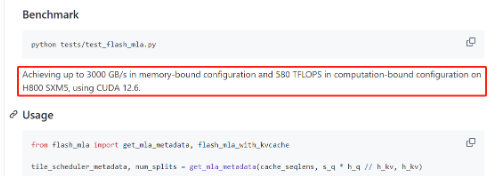

據DeepSeek方面介紹,在基準測試性能表現上,FlashMLA在英偉達H800 SXM5 GPU上可實現3000 GB/s 的內存速度以及580TFLOPS的計算上限。

公開資料顯示,根據美國出口管制規定,H800的帶寬上限被設定為600 GB/s,相比一些旗艦產品有所降低。這意味著,使用FlashMLA優化后,H800的內存帶寬利用率有望進一步提高甚至突破H800 GPU理論上限,在內存訪問上達到極致,能讓開發群體充分“壓榨”英偉達H系列芯片能力,以更少的芯片實現更強的模型性能,最大化GPU價值。

有專注于AI硬件研究并投資的投資人在查看FlashMLA后表示,“FlashMLA是能讓LLM在H800跑得更快、更高效的優化方案,尤其適用于高性能AI任務,他的核心是加速大語言模型的解碼過程,提高模型的響應速度和吞吐量,這對于實時生成任務(如聊chatbot等)非常重要,對于大模型的能力和使用體驗是巨大的促進,速度會明顯提升。”

雖然FlashMLA是一個針對Hopper GPU的優化代碼庫,但對于國產GPU而言,此次開源也有利好。上述投資人在查看FlashMLA后表示,對于國產GPU而言,此次開源算是重大利好。“此前的國產GPU卡,很弱。那現在可以通過FlashMLA提供的優化思路和方法論,嘗試讓國產卡大幅提升性能,即使架構不同,后面國產卡的推理性能提升將是順理成章的事兒”。