京東云昨日宣布,京東云已正式上線DeepSeek-R1 和 DeepSeek-V3模型,支持公有云在線部署、專混私有化實例部署兩種模式,供用戶按需部署,快速調用。

附兩種部署方式:

公有云在線部署

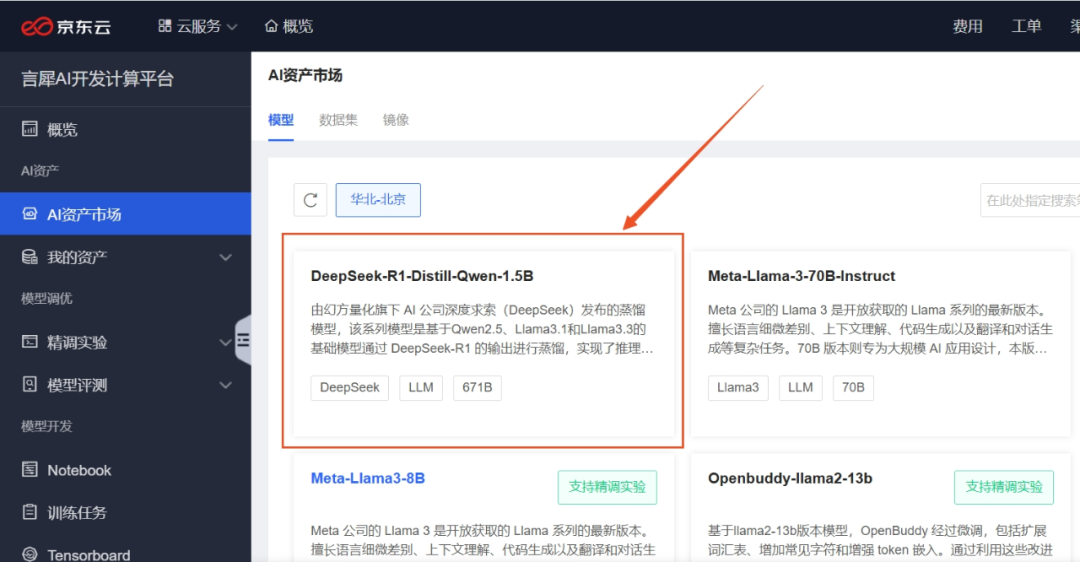

開發者和企業可以在京東云官網,進入言犀 AI 開發計算平臺的“AI 資產市場”中,選用該模型進行一鍵部署。

言犀 AI 開發計算平臺已經支持 DeepSeek-V3、DeepSeek-R1 以及所有蒸餾小參數模型(DeepSeek-R1-Distill)的一鍵部署,具體步驟如下:

1、選擇基礎模型在“AI 資產市場 / 模型”中,提供 DeepSeek 開源的多個版本,如 DeepSeek-R1-Distill-Qwen-1.5B,點擊進入卡片頁可了解模型結構和預訓練數據等關鍵信息,并查看模型文件結構。

2、準備資源節點 在部署時,LLM 模型因為模型較大,資源性能要求較高,需要獨占計算卡進行部署,建議提前準備好專屬資源節點。功能路徑:專屬資源組-創建資源組-創建節點。節點規格:部署 DeepSeek-R1-Distill,推薦使用 cap.p.n3a30.4xlarge;部署 DeepSeek-V3,推薦使用 cap.hc.p5h20.46xlarge

3、模型部署使用將模型部署到相應的服務資源上提供推理調用服務,在部署時平臺將自動適配預置推理框架,實現一鍵部署,僅需指定使用的專屬資源組和對應的節點規格。部署完成后,狀態將會變為運行中,運行中的模型可被調用,提供推理服務。功能路徑:專屬資源組-創建資源組-創建節點在線服務-部署;在線服務-服務列表 | 服務名稱-在線調試

私有化算力實例部署

專混私有化算力實例部署模式,已經同步上線京東云 vGPU AI 算力平臺,為金融、企業、政府等客戶提供數據不出域的私有化模型推理服務。

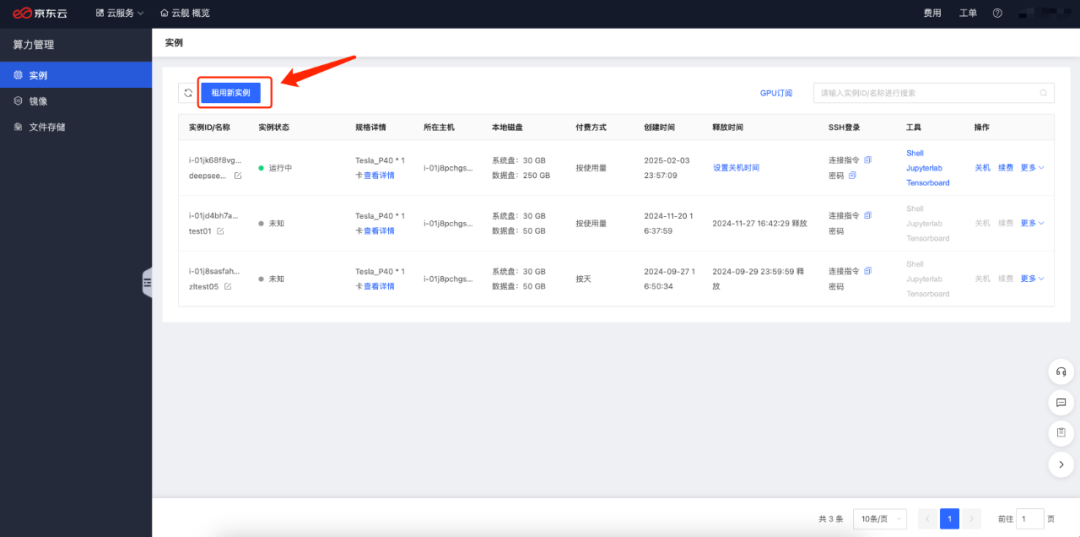

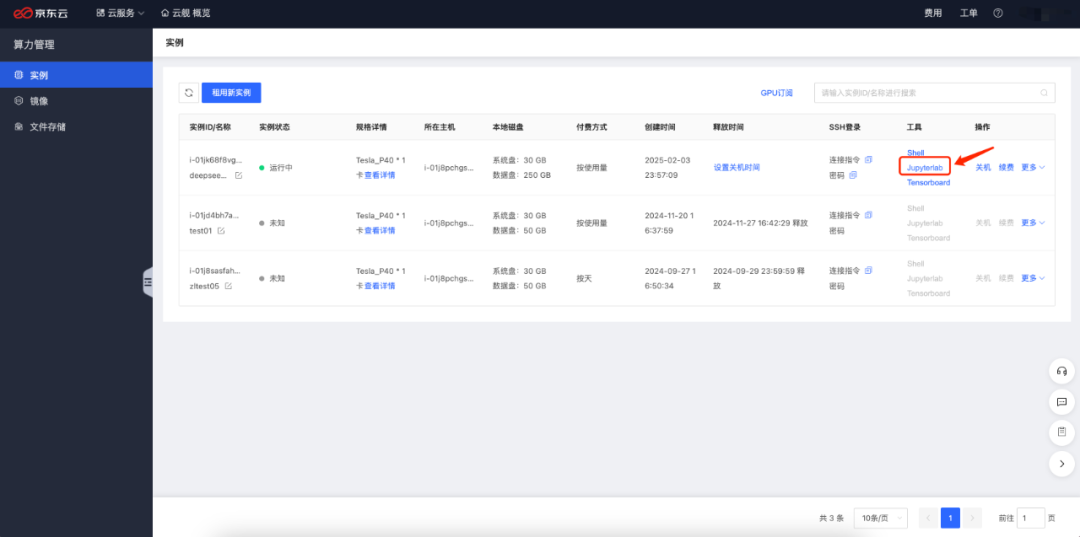

以 DeepSeek R1 版本為例,具體的使用步驟如下:1、進入算力管理頁面,點擊租用新實例按鈕

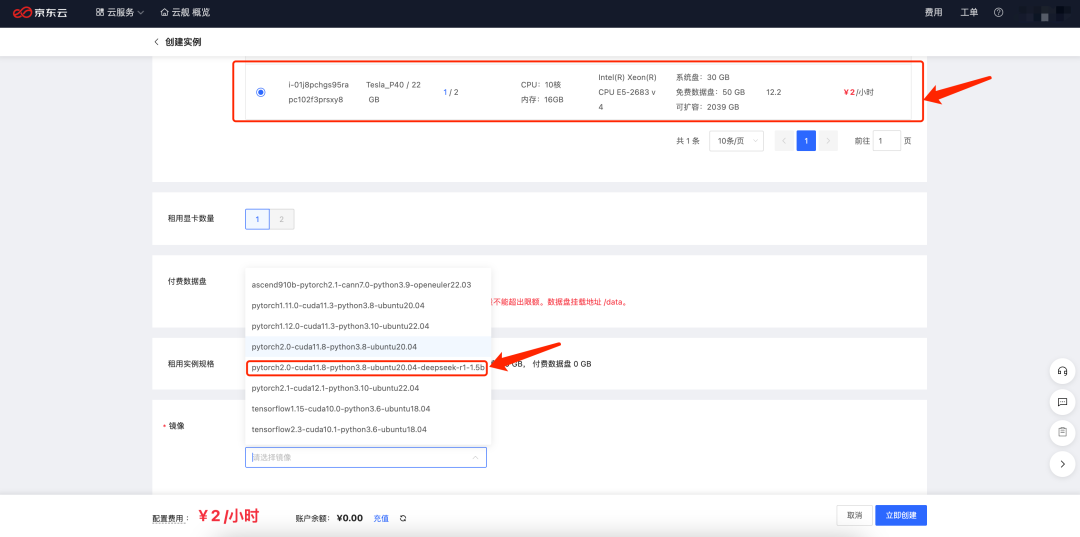

2、選擇資源規格以及對應帶有 deepseek 模型的鏡像

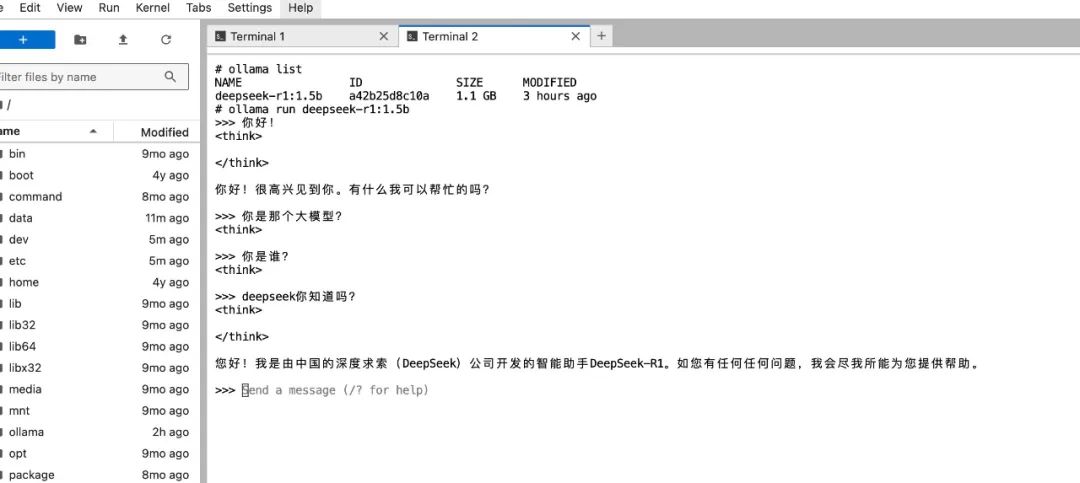

3、資源創建成功后通過 Jupyterlab 進入實例,啟動 Ollama 即可與之對話

京東云言犀 AI 開發計算平臺還支持私有化部署及 API 快速集成,通過自研高性能資源管理與彈性調度系統,可提供大模型的全生命周期服務及部署,涵蓋模型開發、推理及多場景應用擴展。

針對資源緊缺的場景,京東云支持通過蒸餾技術訓練企業自己的大模型,減少模型部署所需資源的同時具備較好的性能。使用京東云 vGPU AI 算力平臺,可以將多個蒸餾過的企業自有模型部署在同一張卡上,有效提升資源利用率 70%。